はじめに

こんにちは。AIチームの村田(X: @em_portero)です。

AI Shiftでは、生成AIリスキリング事業にてチーフエバンジェリストとして企業での生成AI活用を支援するリスキリング研修講師を担当及川(X: @cyber_oikawa)とAIチームで、AI技術の進化をストーリーとして読み解くAI教養ポッドキャスト「AI Shift Academy」を運営しています。

私も台本のためのサーベイに携わっており、この記事ではその中で調べたLLM-as-a-Judgeにまつわるバイアスについてまとめたいと思います。

背景

LLM-as-a-Judgeとは、LLMを評価者として利用し、他のAIモデルの出力や人間の回答の品質を判定する手法です。

いまやLLM-as-a-Judgeは学術/産業を問わずに広く利用されています。LLMを評価者として採用する手法は、その手軽さや高いスケーラビリティにより研究や開発を加速させます。

一方でLLMには学習データなどに起因するバイアスがあり、評価時にはそれらを回避・軽減することが必要です。回避するための第一歩はどのようなバイアスが存在するかを知ることです。

この記事ではLLM-as-a-Judge周辺のバイアスを総覧的にまとめることを目的とします。チートシート的なものになれば幸いです。そのため、原因や回避テクニックなどには詳しく触れません。気になる方は各論文を参照ください。

LLM-as-a-Judgeにまつわるバイアスの分類

一覧

このセクションではサーベイ論文 [Li+ '24] をベースに分類したバイアスを紹介します。

大分類として、

- Presentation-Related Biases:文の表現方法に起因するバイアス

- Social-Related Biases:実社会に関連するバイアス

- Content-Related Biases:文の中身に関連するバイアス

- Cognitive-Related Biases:認知に関連するバイアス

- Scoring-Related Biases:数字を使った採点に関連するバイアス

の5つを採用しそれぞれに分類されるバイアスをテーブル内で紹介します。分類は一つのバイアスが複数のカテゴリーに当てはまる場合もありますが、幅広くカバーすることを重視しました。

Presentation-Related Biases

| バイアス名 | 説明 | 日本語名/別名 |

|---|---|---|

| Position Bias | 入力の位置に基づいて判断を下す傾向。系列の早い段階または遅い段階の応答が、他の位置の応答よりも優先される。 | 位置バイアス |

| Verbosity Bias | コンテンツの実際の価値に関係なく、長さを品質と同一視し、より長い応答を好む傾向。 | 冗長性バイアス / length bias |

| Style Bias | 特定の文章スタイルを高く評価してしまう傾向(e.g. 絵文字/箇条書きを好む)。 | スタイルバイアス |

Social-Related Biases

| バイアス名 | 説明 | 日本語名/別名 |

|---|---|---|

| Authority Bias | 書籍、ウェブサイト、有名人などの権威ある情報源への言及に影響される傾向。 | 権威バイアス / concreteness bias, citation bias |

| Bandwagon-Effect Bias | 大多数の意見に同調する傾向。評価者としてのLLMがコンテンツを客観的に評価するよりも、一般的な見解を優先する。 | バンドワゴン効果バイアス |

| Compassion-Fade Bias | モデル名の削除などの匿名化戦略に影響され、LLMの判断に影響が及ぶ傾向。 | 共感フェードバイアス |

| Diversity Bias | 性別、民族性、その他の社会的分類など、アイデンティティ関連の指標に基づいて判断を変化させる傾向。 | 多様性バイアス |

| Cultural Bias | モデルが学習されていない文化圏の言語や文化を正しく評価できないバイアス。 | 文化バイアス |

Content-Related Biases

| バイアス名 | 説明 | 日本語名/別名 |

|---|---|---|

| Sentiment Bias | ネガティブまたは恐怖を感じさせる応答よりも、陽気または中立など、特定の感情的なトーンを持つ応答を好む傾向。 | 感情バイアス |

| Token Bias | 事前学習中により頻繁または顕著なトークンをLLMが好み、偏った判断につながる傾向。 | トークンバイアス |

| Context Bias | 文脈上の例や文化的背景に影響されてLLMが偏った判断を下し、偏見のある、または文化的に配慮に欠ける結果につながる可能性のある傾向。 | 文脈バイアス |

Cognitive-Related Biases

| バイアス名 | 説明 | 日本語名/別名 |

|---|---|---|

| Overconfidence Bias | 評価判断において過大な自信を示し、過度に断定的だが潜在的に不正確な結論に至る傾向。 | 過信バイアス |

| Self-Preference Bias | 評価者として機能している同じモデルによって生成された出力を好み、客観性を損なう傾向。 | 自己選好バイアス / self-enhancement bias |

| Refinement-Aware Bias | 評価中に、回答がオリジナルか、洗練されたものか、あるいは会話履歴を伴うかによって、スコアリングが変動する傾向。 | 洗練度認識バイアス |

| Distraction Bias | 無関係なコンテンツに影響され、重要な要素から注意をそらすことで判断の質を低下させる可能性のある傾向。 | 注意散漫バイアス |

| Fallacy-Oversight Bias | 論理的な誤謬を見落とす傾向。これにより判断の正確性が損なわれる可能性がある。 | 誤謬看過バイアス |

Scoring-Related Biases

| バイアス名 | 説明 | 日本語名/別名 |

|---|---|---|

| Numerical Bias | 特定の数字を好むバイアス(e.g. 1~10→7, 0~100→42)。 | 数値バイアス |

| Score Rubric Order Bias | 各スコアの説明の提示順序によって引き起こされるバイアス(e.g. 123 vs 321)。 | スコア基準順序バイアス |

| Score ID Bias | スコアの識別子として使用される形式によって生じるバイアス(e.g. 123 vs 一二三)。 | スコアIDバイアス |

| Reference Answer Score Bias | プロンプトに提示される参照回答に特定のスコアを付与するかどうか、またそのスコアの値によって引き起こされるバイアス。 | 参照回答スコアバイアス |

バイアスの詳細

このセクションではいくつかのバイアスについて、論文をピックアップしながら詳細に触れようと思います。

Position Bias

[Chen+ EMNLP '24] ではリストワイズ評価におけるモデルごとのバイアスを評価しています。例えば、Mixtralは最初の選択肢を好むがSparkは2番目を好むという傾向が観察されました。モデルごとに異なるバイアスが存在することは使用者として注意すべきでしょう。人間(少なくとも筆者)はマークシート形式で最初の選択肢を選びにくいですが、LLMはそうではないというのも意外な結果でした。

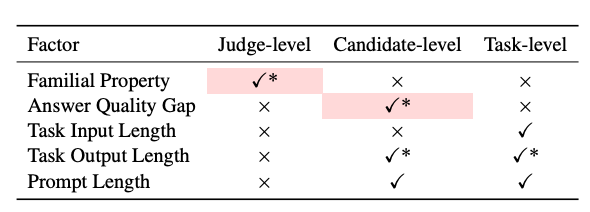

また、[Shi+ '24] では要因ごとにPosition Biasに与える影響を分析しています(下表)。回答品質のギャップが小さいほどバイアスの影響を受けやすく、モデルファミリーごとにバイアスの強さが異なることを報告しています。

Self-Preference Bias

評価者と回答生成者が同じモデルであることで発生するこのバイアスは原因の分析が進んでいます。

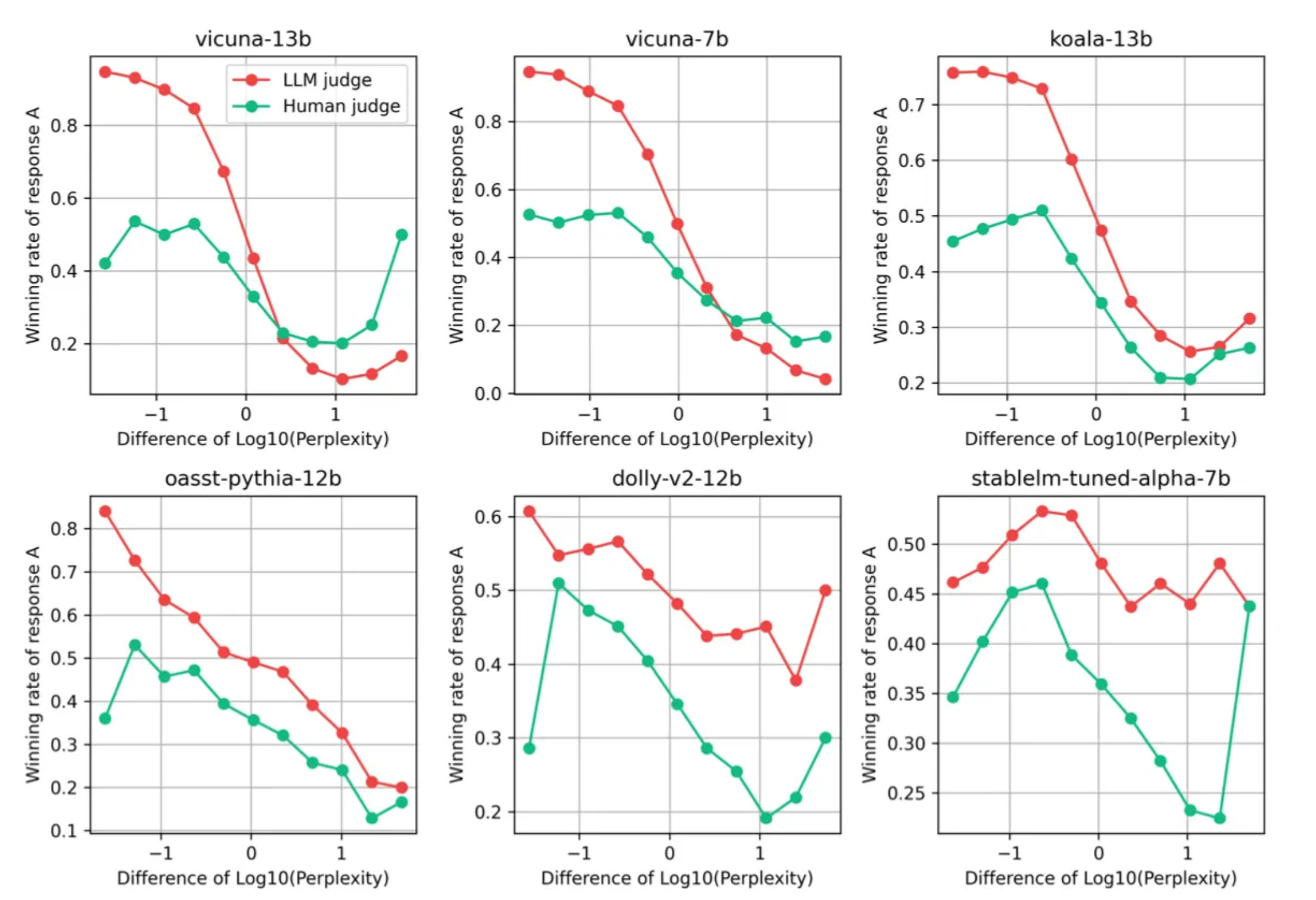

[Wataoka+ '24] ではPerplexityが低い回答を好みやすいことが原因であると主張しています。実験ではPerplexityが低い回答をLLMが人間よりも顕著に好むことが示されました(下図)。

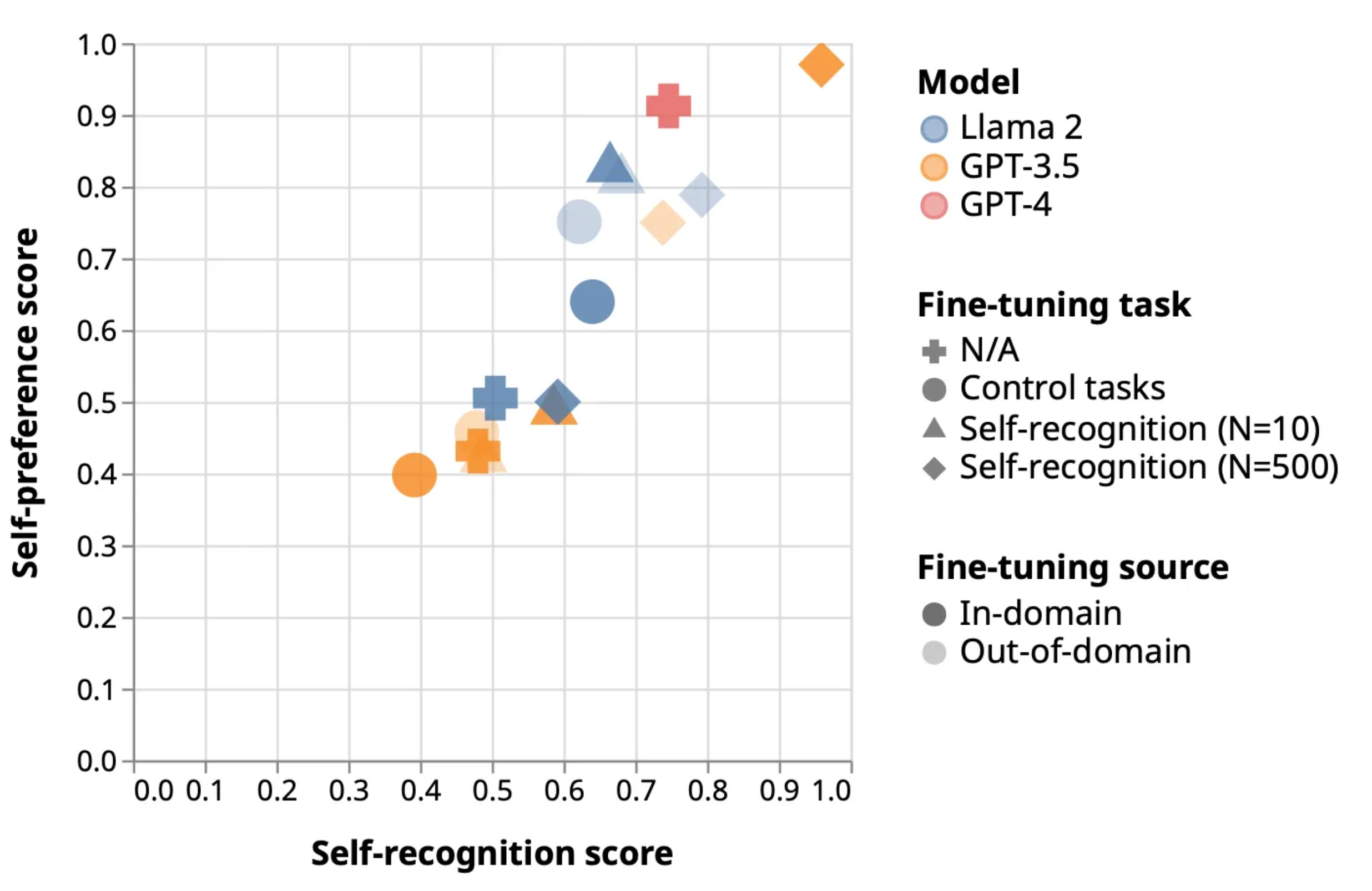

[Panickssery+ NeurIPS'24]ではLLMの自己認識を定量化し、それとPosition Biasに正の相関があることを示しています。

また、完全に同一のモデルだけではなく同じモデルファミリーに属するモデルを使用することでバイアスが発生することも報告されています [Li+ '25] 。

学習データやアーキテクチャが類似する同じファミリーではPerplexityなども類似することが要因だと考えられます。

Sycophancy

バイアスの分類のひとつではありませんが、LLMを使用するときの問題として Sycophancy(おべっか、追従性)があります。ユーザーの信念や反論に合わせて、初期の評価や判断を容易に変更してしまう傾向です。

[Kim+ '25]では、この追従性がやり取りの形式によって大きく左右されることを調査しています。彼らは、LLMがLLM-as-a-Judge的な設定、すなわち相反する複数の議論を単一のターンで同時に評価するよう求められた場合と比較して、ユーザーからのフォローアップとして反論を提示される対話的な評価設定の方が、反論を認めやすく、自身の初期の判断を維持しにくいことを指摘しています。

原稿などをLLMでレビューするときは意識すると良いかもしれません。

おわりに

本記事ではLLM-as-a-Judgeにまつわるバイアスを総覧的にまとめました。LLM-as-a-Judgeを利用する方の頭の片隅に残り、より良い評価に繋がれば嬉しいです。

冒頭に触れたAI Shift Academy該当回のリンクは以下となります。ぜひご覧ください。