こんにちは。AIチームでデータアナリストを担当している柾屋(まさや)です。AI Shift Advent Calendar 2022の19日目の記事になります。

本記事では、文系ビジネス職からデータアナリストになるまでに行ってきたことや、実際に業務として取り組んでいる内容について記載しています。

これからデータアナリストを目指している方や興味を持っている方の参考になればと思います。

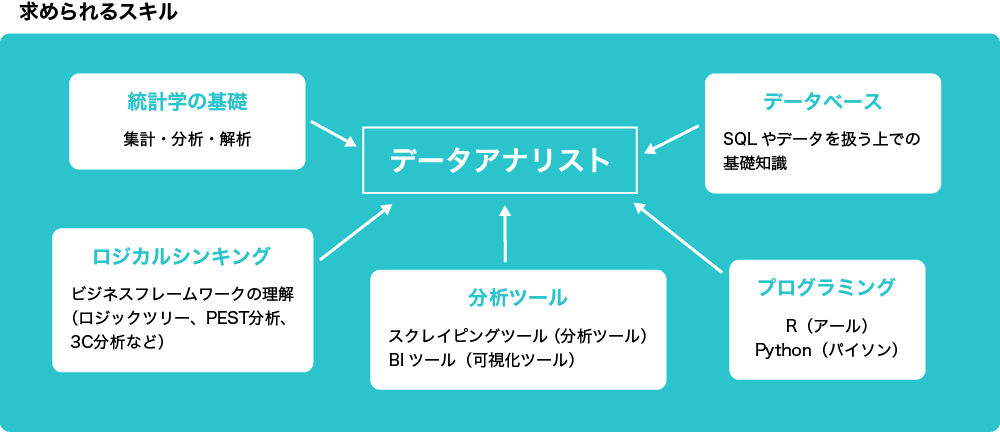

そもそもデータアナリストとは

分析する人

データアナリストと言っても企業によって業務内容や役割が異なっている為、一概にこれ!といった定義は難しいと言われています。

調べてみると

- 収集した情報を分析するプロフェッショナルのこと

- データの分析を行う者

- データの処理や現状分析などのフェーズを専門に行っている職業

などと定義されていました。”アナリスト”と呼ばれるくらいなので、分析をする仕事であることは分かりました。

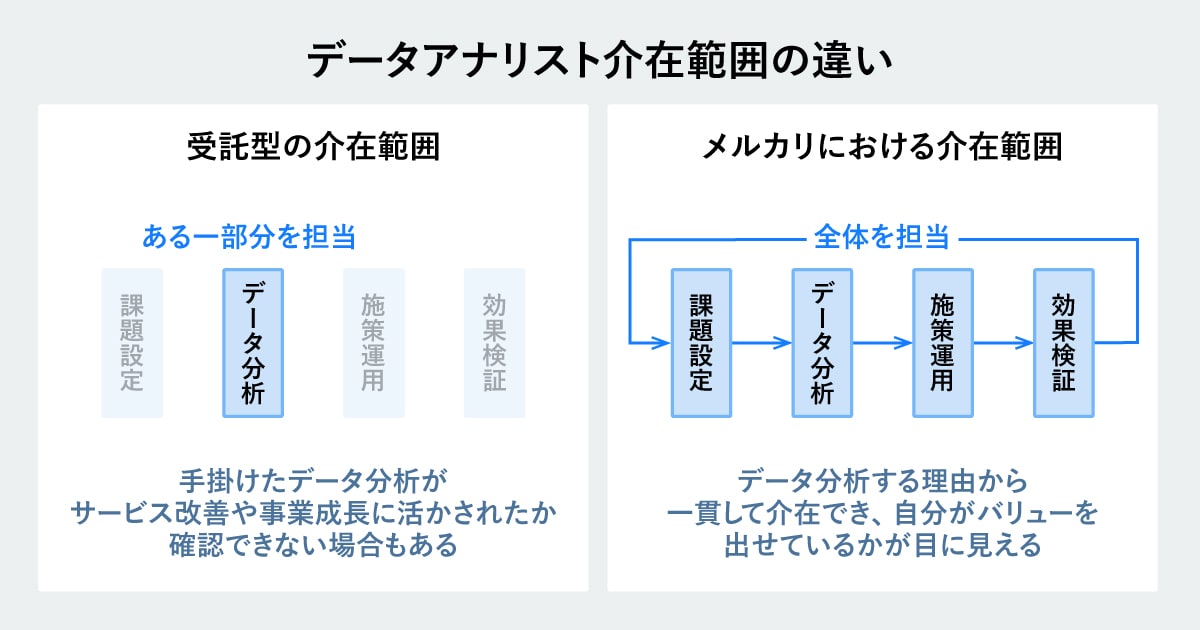

所属する業界・企業によってコミットの仕方が異なる

データアナリストの定義は企業によって異なると記載しましたが、分かりやすい例の1つとして仕事におけるコミットの仕方があります。

例えば、コンサルティング会社のように自社でデータを持っていない立場では、クライアント(お客さん)のデータを共有してもらって分析を行います。当然、全てのデータが共有してもらえるという訳ではなく、かつ、提案を前提として、仮説検証のための分析を様々な視点で行います。

一方で、アプリ制作会社のように自社でデータを持っている立場では、ほぼ全てのデータを分析の対象とすることができます。大量のデータからユーザーインサイトを見つけたり、機能改善としてA/Bテストの結果を分析したりなど業務は多岐に渡ります。

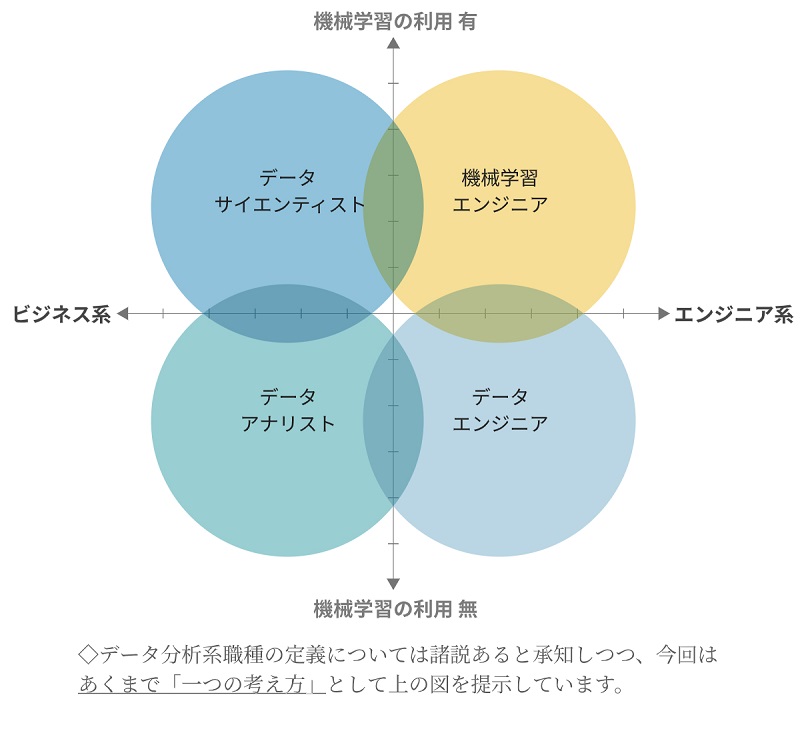

どの業務までコミットするかによって呼び名が変わる

データアナリストの定義が難しい理由の1つとして、関連する業種が幅広く、場合によっては兼務しているような人も多いためです。

例えばData Analytics ConsultantのSasiさんによると下記のようなデータに関連する職種があるようです。

データサイエンティスト(Data Scientist)

統計や分析手法を用いてデータからインサイトを抽出する人。

予測モデルの作成やデータパイプライン(データをソースから取得、処理し、データを保存するまでの流れ)の構築、データの可視化などのタスクをこなす。

データエンジニア(Data Engineer)

データを活用するためのインフラを構築、維持する人。

企業がビジネスでデータを活用できるように、データの整理・管理やデータ分析基盤の設計・構築をする。 データはそのままの状態では点在していたり、欠損しているため上手く活用できないため、データエンジニアが活用できる形にデータを加工をする。

ビジネスインテリジェンスアナリスト(Business Intelligence Analyst)

データを活用して、より良いビジネスの意思決定をサポートする人。

ダッシュボードのデザインやレポートの作成、可視化を行い、意思決定をするためのインサイトを提供する。

データアナリスト(Data Analyst)

データを活用して、インサイトや意思決定のサポートをする人。

点在するデータソースから必要なデータを集め、分析できるように加工をする。統計知識を活用して分析を行い、インサイトを提供する。

機械学習エンジニア(Machine Learning Enginner )

機械学習を用いて問題を解決する人。

アルゴリズムを作り、機械学習モデルの学習や評価を行い、サービスへと機械学習モデルを組み込む人。

データアーキテクト(Data Architect)

組織のデータインフラストラクチャの設計と実装に関与する役割の人。

データ モデルの定義、データ ストレージ ソリューションの実装、データの整合性とセキュリティの確保などの業務を行う。

データベースアドミニストレーター(Database Administrator)

組織のデータを格納するために使用されるデータベースの管理と維持に関与する役割の人。

データベースの構成と最適化、問題のトラブルシューティング、可用性とパフォーマンスの確保などのタスクに取り組む。

データクオリティマネージャー(Data Quality Manager)

組織のデータの正確性、完全性、信頼性を保証する役割の人。

データ品質基準の定義と実装、監視、改善などのタスクに取り組む。

データビジュアライゼーションスペシャリスト(Data Visualization Specialist)

データを可視化して、洞察と発見を伝えるのに役立つ役割の人。

ビジュアライゼーションを設計および作成し、ソフトウェア ツールを使用してインタラクティブで分かりやすいビジュアライゼーションを作成する。

データプロダクトマネージャー(Data Product Manager)

顧客やユーザーに価値を提供するデータ駆動型のプロダクトの要件定義および構築する役割の人。

顧客のニーズの特定や、プロダクト要件の定義、データ サイエンティストやエンジニアとのコラボレーションなどのタスクに取り組む。

どの立場でも共通する点は”経営の意思決定”をサポートしているという点

データアナリストは定義が難しいという話をしてきましたが、”何のために分析をするのか?”という点において共通点があります。

それは、「経営の意思決定をサポートするために分析をする」という点です。

データを集める、加工する、分析するといったタスク自体はビジネス価値はありません。経営判断や事業発展につながるようなインサイトの提供、意思決定のサポートができてはじめて価値が生まれると考えています。

この目的のために、

- どのようなデータを扱うのか?

- どのような手法を使って分析をするのか?

- 分析した結果からどのようなインサイトを見つけられるか?

がデータアナリストの腕の見せ所と言ってもよいでしょうか。

なぜデータアナリストになろうと思ったのか?

計画された偶然性による出会い

さて本題です。なぜデータアナリストになろうと思ったのか。それは、時間を忘れて没頭することができたからです。

米国スタンフォード大学のジョン・D・クランボルツ教授が20世紀末に提唱したキャリア理論の1つに「計画された偶発性理論(Planned Happenstance Theory)」があります。

「“個人のキャリアの8割は予想しない偶発的なことによって決定される”とし、その予期せぬ偶然の出来事にベストを尽くして対応する経験の積み重ねで、よりよいキャリアが形成される」という考え方です。

これまでのキャリア理論では、予め設定したキャリアゴールを目指してキャリアを積んでいく「キャリアアンカー理論」が主流でしたが、今の変化の激しく、様々な職業が新しく生まれている時代にはフィットさせることが難しいと言われています。

私のこれまでのキャリアを振り返ると、まさに”計画された偶発性理論”によって形成されてきたものでした。

ザ・営業からキャリアをスタート

私のキャリアのスタートはマーケティングリサーチ会社のコンサルティングセールスです。何となく”世の中の真理が知りたい”という気持ちから、”見えないものを可視化できる”リサーチ業界に興味を持ったのがきっかけです。

文系出身でプログラミング経験はゼロ、統計知識なども大学の授業で習った内容の大半を忘れてしまった状態で、分析をしたいというよりは、分析して出てきた面白いインサイトにたくさん触れたいという気持ちが強く、セールスの部署に配属希望を出しました。

私は国内外大手代理店と外資コンサルを担当しており、マーケットリサーチを通して得られた市場分析やコンセプト調査、プロモーションの効果検証などの案件が多かったです。

インサイトを見つけるという点では楽しく仕事ができていたのですが、次第に上流部分だけでなく、下流部分まで一貫して関わってみたいという思いが強くなり、そのタイミングでCyberAgentに転職をしてきました。

業務の幅を広げたことで見えてきたこと

CyberAgentの最初のミッションは立ち上げたばかりの事業の売上責任を持つ事でした。デジタル広告について多少の知識しかなくペーペーの状態で、売上ゼロの状態から月に何千万円を作るという目標でした。

業務としては新規アドネットワーク広告の企画・開発、コンサルティング営業、広告運用と事業に関わることなら全てやるというスタンスです。当然、ほぼ未経験に近いので、他のメンバーの方の方が詳しいですし、仕事もスピーディーです。

全てのスキルセットが相対的に劣っている状態の中で、「自分はこの責務の中で何をすべきなのか?」とかなり悩んだ結果、事業として足りていないところは全てやろうと決め、本当に様々な業務に取り組みました。

多くの業務の中でも、”時間を忘れて没頭している”業務と、そうではない業務があるということに気づきました。

私が“時間を忘れて没頭していた業務“は,“分析業務“でした。

“得意な事か?”ではなく”没頭できる事か?”を軸に選んできた

CyberAgent内での仕事は驚くほど変化が激しく、業務範囲は多岐に渡ります。

部署やミッションが変わり、業務が変わる中でも一貫して”分析業務”だけは時間を忘れて没頭できる存在でした。

今のAI Shiftに異動した後に強く実感し、その後の業務については”なるべく没頭できるもの”に自分の業務時間を使えるようにしていこうと、キャリアを考えるようになりました。

単に”没頭できること”を業務として選ぶだけだと、キャリアとしての成長が感じられないと思ったので、”今できることプラスアルファ”の業務にチャレンジするようにしてきました。

その結果、もともとExcelやGoogleスプレッドシートを活用した分析がメインだったのですが、BIツールの1つであるTableauを活用し始め、RPAやGASを使い始め、今では”Python”を使った分析をメインに取り組むようになりました。

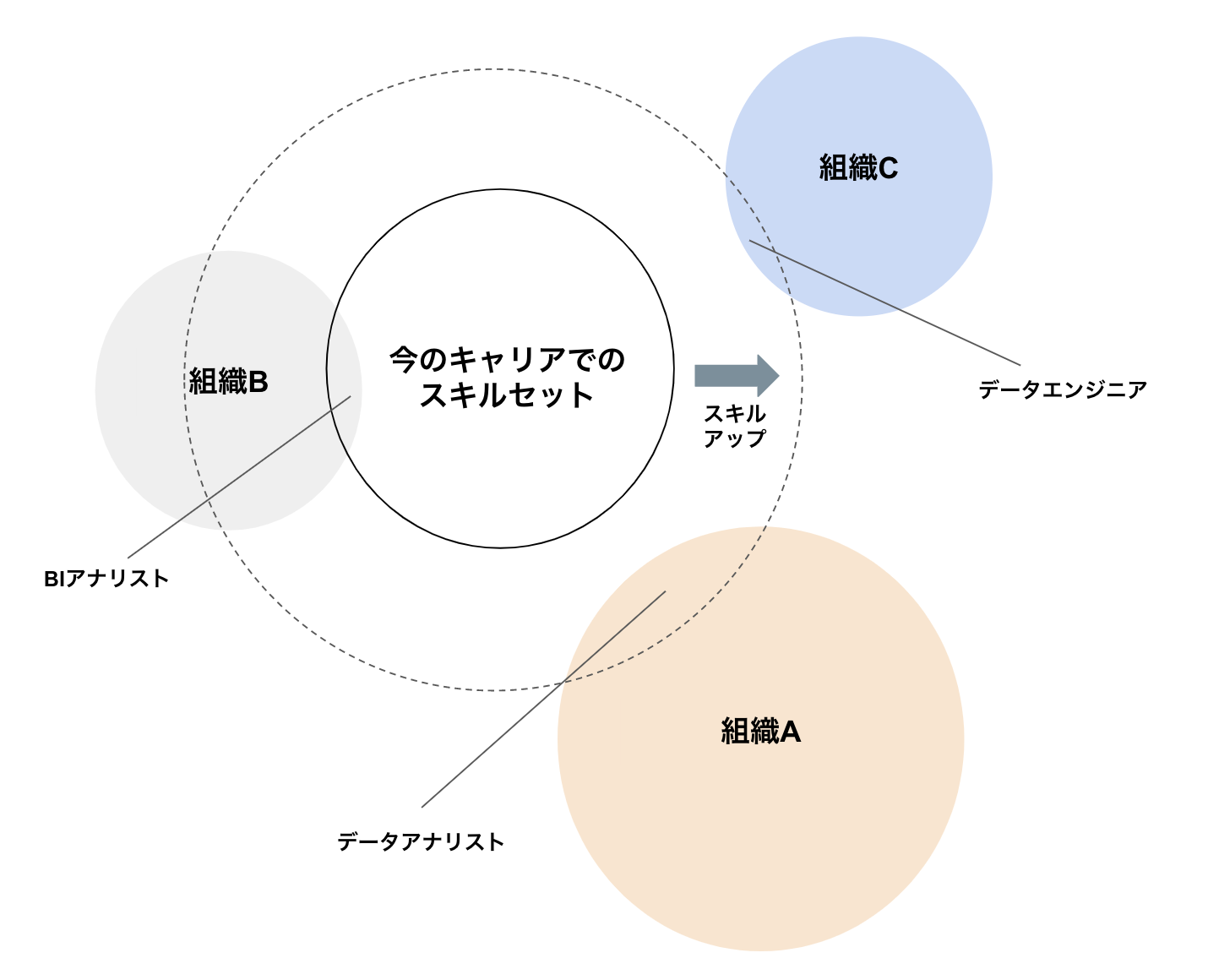

組織の方針とキャリアの方針の結果が今のポジション

どこの組織に所属するかというのはキャリアを形成する上で、大きく影響を受ける点だと思います。

事業の方針と個人としてのキャリア方針がマッチしてはじめてポジションが生まれるからです。

私の場合は幸運にも、今の組織にデータサイエンティストや機械学習エンジニアのチームがあったため、そこの中にデータアナリストというポジションを作ってもらうことができました。

もし組織が異なっていた場合は、データアナリストというポジションではなく、ビジネスインテリジェンスアナリストやデータエンジニアというポジションになっていた可能性もあります。

そのため、私の場合は、”データアナリストになるべくしてなった”という訳ではなく、”計画された偶然性理論”によって積み上げていったキャリアの方針と今の組織の方針が重なった点が”データアナリスト”であったという解釈の方が正しいかもしれません。

今後も”没頭できることプラスアルファのチャレンジ”をしていくことで、ポジティブな意味で、データアナリストから他のポジションに変わっていくのかなぁと考えていたりもします。

データアナリストになるまでにやったこと

これまでのキャリアの積み重ねの結果でデータアナリストになったと記載しましたが、具体的にスキル面だとどのようなことをやってきたのかということをザックリとまとめていければと思います。

特にビジネス職の方やこれからデータアナリストを目指す人の参考にしていただければと思います。

基礎PCスキル

1.ブラインドタッチの取得

新卒研修で実施していましたが、できる・できないで大きく業務効率が変わりました。

2.Excelやスプレッドシートなどのショートカットの取得

こちらもWindowsやMacなどの利用するPC環境で異なりますが、業務スピードがかなり変わりました。

分析初級スキル

3.Excelやスプレッドシートの関数を一通り実施できるようにする

IF, VLOOK, SUMIFS, COUNTIFSなど関数を使いこなせると、BIツールやPythonなどのプログラミングでも上達が早いと感じました。

4.Excelやスプレッドシートで自動レポートを作れるようになる

IMPORTRANGE, ARRAYFORMULA, UNIQUE, TRANSPOSEなどを使ってCSVを張付けるだけで自動でグラフ作成やクロス表作成などが組めるようになると、プログラミングの際に、どのようなコードを書けばよいかという視点に活かせると思います。

分析中級スキル

5.BIツールでデータ加工やダッシュボード作成ができるようになる

TableauなどのBIツールでレポートのダッシュボードを作れると、ゴールイメージを持てるようになるため、論理立てた分析をする能力を伸ばすことにつながると感じました。これは、プログラミングをする際にも大いに活かすことができます。

6.今の組織で活用しているデータテーブルを整理してみる

データを分析するにあたり、どのようにデータが溜まっているのかを把握していることは重要です。データ分析のファーストステップとして、どういったカラム(日付、顧客IDなど)があり、どういった粒度(daily,timestampなど)でデータが格納されているのかを整理してみると、より構造的にデータを把握できます。

構造的にデータを把握することで、現状のデータでどのような分析ができるのか、他のデータベースと繋ぎ合わせて分析ができそうかなどを考えることができるようになります。

プログラミング初級~中級スキル

7.データサイエンス100本ノック(構造化データ加工編)をやってみる

Pythonの入門編として私は100本ノックから始めました。こちらのサイトにどのようにスタートするのかや回答まで丁寧に記載されています。私はPCの環境設定などが不要なGoogle Colabを使う場合を4-6周ほど繰り返しました。

最初はやり方すら分からないので、回答を見ながら少しずつ解き進め、回答を見てもどのような処理がされているか分からない場合は、都度、ググって知識をつけていきました。

回答を暗記して何も見ずに解かなければいけない学校のテストと異なり、プログラミングではベストプラクティスをどんどんコピペして、覚えるよりも、とりあえず使ってみるということが上達の近道だと実感しました。

8.Google Apps Script(GAS)を使って簡単なプログラムコードを実装する

自動メール送信BOTを作成などができると、ある程度プログラミングを理解することができます。関数の定義やどのような処理をするのかは、一度ルールを把握できれば意外と想像してたほど難しくないと感じると思います。

私がGASを使って業務効率化をした事例をこちらにまとめていますので、よろしければ参考にしてみてください

9.SQLを書いて欲しいデータを取得してみる

分析に必要なデータはデータベースやデータストアに格納されており、SQLでクエリを書くことでデータを抽出します。私の組織ではGoogle Cloud Platformを活用しているため、BigQueryを使ってデータを抽出しています。

ある程度データ分析スキルが高まったタイミングでSQLのスキルも取得ができると、より分析の幅が広がります。

10.GitHubを使ってみる

ある程度コードが書けるようになると、他の人にもコードを共有する機会や、コードの修正にフィードバックをもらう機会が増えてきます。

GitHubはコードを管理するサービスで、多くの企業が使っているものなので、一度使ってみると共同開発や煩雑にならないコード管理の思考を勉強することができます。

かく言う私も、GitHubを使って色々教えてもらっている真っ最中です(笑)。

今の仕事内容

最後に今の仕事内容について記載します。企業によってデータアナリストとしての職務やミッションが異なるため、あくまで1例として見ていただければと思います。

Tableau(BIツール)関連

AI ShiftではTableauを活用してレポーティング業務を行なっています。データアナリストになる前からTableauを使ってダッシュボード作成などは行なっていましたが、現在はより上流部分のデータソース関連の作成やメンテナンス業務を行なっています。

TableauではBigQueryに格納されているいくつかのデータテーブルを結合させて利用しており、サービスの機能改修によって新たに変数が加わったり、レポートでデータソースにない項目を参照したい際などにSQLを改修しています。

自動化周り

チーム内のチャットボットやボイスボットの実績共有やクライアントへのレポート報告業務の1つとしてGoogle Apps Script(以下 GAS)を利用した自動化プログラムを実装しています。

SQLで欲しいデータを取得して、GASでメール送信用にデータを加工し、自動送信をするなどのプログラムを作成、メンテナンスをしています。

A/Bテストの評価周り

A/Bテストを実施した後の評価として、ベイズ推定を活用した評価を行なっています。もともと統計知識はあまりなかったので、学習しながら評価方法の改善を図っているという段階です。

こちらでベイズ推定を用いたA/Bテストの評価についてまとめていますので、もしよければ参考にしてみてください。

事業価値向上につながるインサイトを見つける

もともとクライアント(お客さん)別にチャットボットやボイスボットの個別最適化をしていく運用体制はありましたが、全体最適やベストプラクティスを作っていくという動きをするポジションの人がいませんでした。

そこで横断的にデータ分析をすることで、これまで見えなかった全体傾向やトレンド、ベストプラクティスの仮説を立てるなどのインサイト提供を行っています。ここで出てきた仮説をベースにA/Bテストをして、サービス全体の品質向上につながるようにしています。

まとめ

本記事では、データアナリストになるまでの経緯と、実際にどのような業務を行っているのかの紹介をしました。私自身まだ勉強中という段階ですが、少しでもデータアナリストとしてのキャリア選択をする上で参考にしていただけると嬉しいです。

明日はAIチームの下山から「測度による積分への(多分)最短コース」についての記事がでる予定です。

そちらもご覧いただけますと幸いです。