はじめに

こんにちは、AI チームの長澤 (@sp_1999N) です。

弊社では AI Worker という LLM エージェント構築プラットフォームを提供しています。

LLM エージェントを運用していると重要な要素になるのが「可観測性 = Observability」になります。

複雑な推論や複数のアクションを前提とした LLM エージェントでは、その挙動をいかに監視するかが運用上重要なトピックになります。

LLM エージェントの Observability 基盤としては、Datadog など様々な企業からサービスとして展開されており、また OSS として使えるものも多数出現しています。このことからも、LLM エージェントを自社サービスとして提供する場合は、可観測性が重要であることが伺えます。

一方で増えつつある選択肢の中から、どれを選べば良いかというのもよくある悩みです。

そこで今回は、多く存在する LLM エージェント Observability 基盤を網羅的に紹介してみようと思います。

注意: この記事の内容は 2025/7 時点の情報をベースにしておりますのでご注意ください。エージェントの Observability 基盤は急成長領域であるため、必ず各種プラットフォームの公式ドキュメント等を参照することを推奨します。

早見表

サクッと比較したい方向けに、早見表を記載しております。一言はあくまで自分の所感になります。

| OSS | プロンプト管理 | 評価基盤 | SDK | 一言 | |

| Braintrust | × | ⚪︎ | ⚪︎ | Python, TS, Ruby, Java, Go, Kotlin | エージェントやツール管理までできるend-to-end なプラットフォーム |

| Dash0 | × | × | ⚪︎ | Python, JS/TS, Go, Erlang, Java, .NET言語, Ruby | ランチャーやマルチテナント対応など本番想定での使い勝手の良さが特徴 |

| LangSmith | × | ⚪︎ | ⚪︎ | Python, JS/TS | LangChain エコシステムとのシームレスな統合 |

| New Relic | × | × | △ | Python, JS/TS, .NET言語, Java, Go, Ruby | 汎用 APM という立ち位置。MCP の呼び出しもトレースしてくれる |

| LangWatch | △ | △ | ◎ | Python, TS | Scenario を使ったエージェントのシミュレーション評価が可能 |

| Datadog | × | × | ⚪︎ | Python, Java, JS/TS | Ragas など off-the-shelf な llm-as-a-judge の評価が可能 |

| Traceloop | × | ⚪︎ | ⚪︎ | Python, TS, Go, Ruby | OTel を LLM 向けに拡張した標準規格である OpenLLMetry 提供 |

| Phoenix | ⚪︎ | ⚪︎ | ◎ | Python, TS | 検索やエージェント評価まで対応した充実した評価基盤を持つ |

| Langfuse | ⚪︎ | ⚪︎ | ⚪︎ | Python, JS/TS | カスタムダッシュボードなど UI/UX 面で優れる |

| Laminar | ⚪︎ | △ | ⚪︎ | Python, JS/TS | キューを使ったデータのラベル付けが可能 |

| SigNoz | ⚪︎ | × | × | Python, JS/TS, Java, Go, PHP, .NET言語, Ruby, Elixir, Rust, C++, Swift | 汎用 APM という立ち位置で他フレームワークとの統合で利用 |

| Langtrace | ⚪︎ | ⚪︎ | ⚪︎ | Python, TS | 2行の実装でトレースが可能な手軽さが魅力 |

紹介する Observability 基盤の選定

弊社で開発している AI Worker では、開発言語として TypeScript、エージェントフレームワークとして Mastra を採用しています。(AI Shift における開発体制については こちらのブログ で述べていますので、興味のある方はぜひどうぞ!)

そこで今回はこのような背景を踏まえ、以下を選定の条件とします。

- SDK として TypeScript がサポートされていること

- データ収集基盤だけでなく、評価・分析基盤まで提供されていること

今回は TS を対象言語としていますが、多くのプロバイダーは Python も同時にサポートしているため、Python で開発されている方にとっても参考になる内容になっていると考えられます。また Go や Ruby などをサポートしているフレームワークも存在するので、言語軸で調べられている方の足掛かりにもなれば幸いです。

比較対象とする Observability Providers

条件を踏まえ、まずは Mastra 側の情報をチェックしてみます。

Mastra の公式ドキュメントには Observability Providers のリストが公開されています。

これだけでも多くのプロバイダーが存在することが分かります。数は多いですが、せっかくなのでそれぞれ特徴を紹介してみようと思います。また Datadog, Arize AI の Phoenix, Langtrace も LLM Observability プラットフォームとしてツール提供しているため、これら3つも紹介の対象に加えたいと思います。

1つ紹介の軸として、OSS としてセルフホストが可能かどうかを設けて整理したいと思います。

Non-OSS プロバイダー

このセクションで紹介するプロバイダーは全て non-OSS なサービスとして開発されているものになります。

商用レベルの利用では基本的に有料ですが、趣味としての個人開発やトライアルとして無料で使えるプランも用意されているものがほとんどです。

それぞれの特徴を簡単に見てみます。

Braintrust

Braintrust は2023年に設立されたスタートアップで、a16z などの著名なベンチャーキャピタルからの出資を受けています。利用企業には instacart, stripe, Notion など有名な企業が並びます。

OSS としては開発されていませんが、Python や TypeScript 以外にも Go や Ruby など様々な言語で SDK を提供してくれています。監視や評価基盤だけでなく、LLM エージェントそれ自体やエージェントに提供するツールなども構築できる、end-to-end なプラットフォームとして展開されているのが特徴と言えそうです。(Agent の作成機能は執筆時点では beta 版としての提供のようです)

Free plan も用意されており、個人プロジェクトなどの小規模な利用の場合はこのプランで試してみるのも良いかもしれません。

Dash0

Dash0 も2023年に設立され、ニューヨークに拠点を置く企業になります。OpenTelemetry ネイティブな監視基盤を提供しています。SDK としてこちらも JS/TS, Python, Go, Ruby, Java など複数の言語をサポートしています。こちらも OSS ではなく、セルフホストなどはできません。

こちらも、監視から評価までを一貫して提供してくれています。その上で、プラットフォーム内にランチャーが用意されているなど使い勝手の良い印象です。またマルチクライアント・マルチテナント対応やアクセスコントロール、アラート通知の設定が可能になっていたりと、本番利用に向けた充実した機能が揃っています。

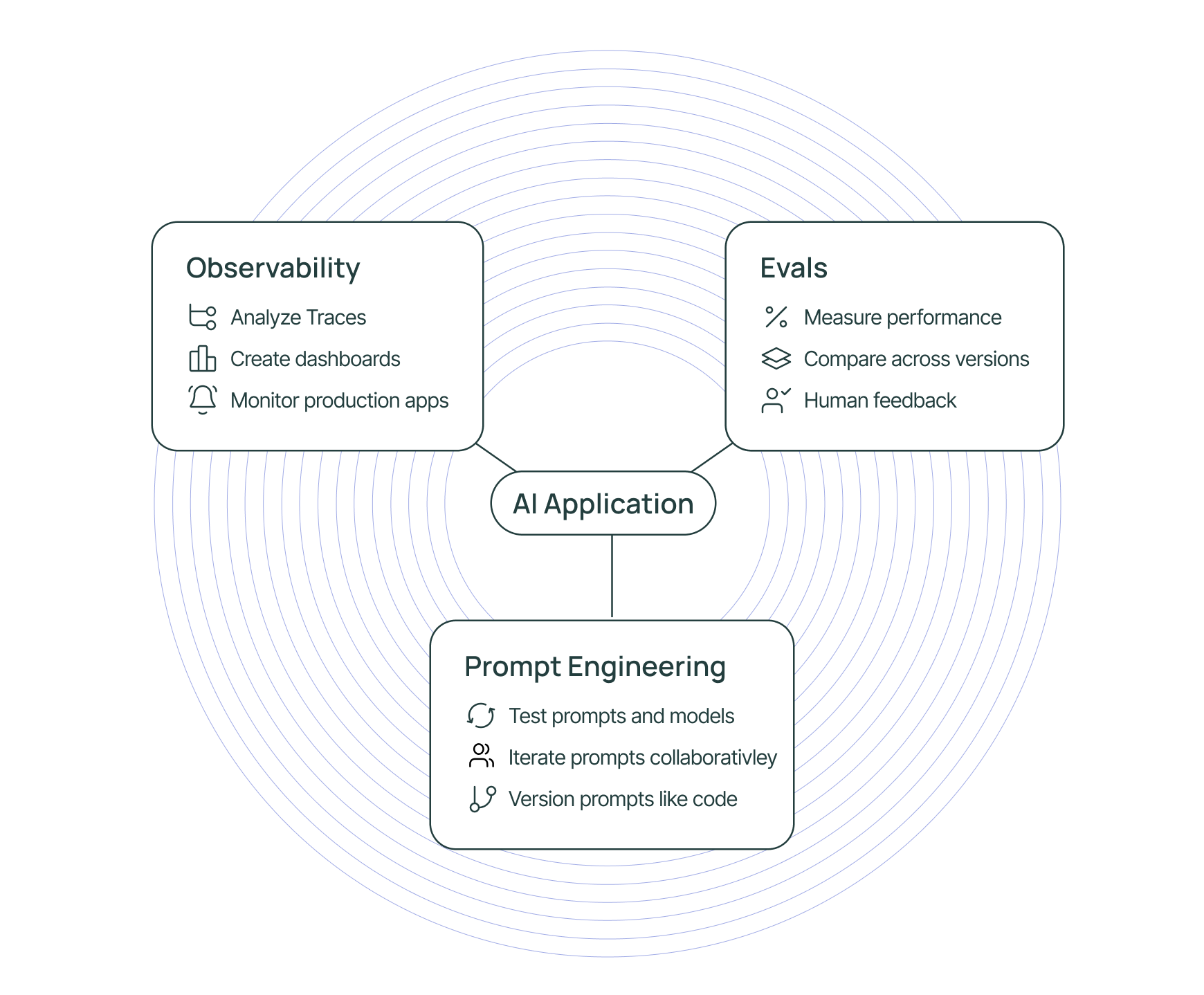

LangSmith

LangSmith は、お馴染み LangChain 社が展開するプラットフォームの1つです。趣味の範囲での個人開発であれば無料で利用できますが、商用の場合は有料となります。また LangChain がそうであるように、LangSmith においてもサポートされる言語は Python と JS/TS のみになります。

Observability, Evals, Prompt Engineering の3要素を柱として構成されています。

最大の特徴は LangChain エコシステムとのシームレスな統合であると考えられます。LLM アプリケーションのフレームワークとして LangChain や LangGraph を使用している場合、環境変数の設定のみを行えば、基本的には追加コードなしでトレースができるようになります。

その一方でフレームワーク非依存な提供であるため、LangChain エコシステム以外にも組み込むことが可能で、実際に各種商用 LLM プロバイダーや Vercel AI SDK とのインテグレーションなどが提供されていたりします。

New Relic

New Relic は 2008 年にサンフランシスコで設立された、APM (Application performance monitoring) ツールを提供する企業です。他のプロバイダーと比較するとその立ち位置としては Datadog に近いと言えます。

AI Monitoring として、AI アプリ向けの APM ソリューションを提供しています。対応言語には Go, Ruby, JS/TS, Python などがあります。

MCP の呼び出しに関してもトレースを行い、そのパフォーマンスの監視も行ってくれます。ただし、他プロバイダーが押し出しているような「評価」に関する機能については、現時点ではユーザーフィードバックの収集程度にとどまっているようです。

LangWatch

LangWatch は 2023 年にオランダで設立された LangWatch 社によって提供される LLMOps プラットフォームです。ライセンス自体は Business Source License 1.1 になるので、OSS には分類されません。セルフホストでの運用も可能ですが、商用利用の場合は有料プランでの契約が必要になる点にご注意ください。対応言語は Python および TypeScript のようです。

エージェントの評価に力を入れたプラットフォームになっており、Scenario と呼ばれるエージェントテストフレームワークが独自に導入されています。これはマルチターンの行動を前提とした LLM エージェントを、シナリオベースでマルチターンに評価するためのものになります。多くのプロバイダーを紹介していますが、このようなユーザーシミュレーター機能を備えたものは他ではあまり見当たらなかったため、大きな特徴と言えます。

また有料機能として Guardrails があり、ハルシネーションやセンシティブデータの漏洩などをリアルタイムで検知してくれます。

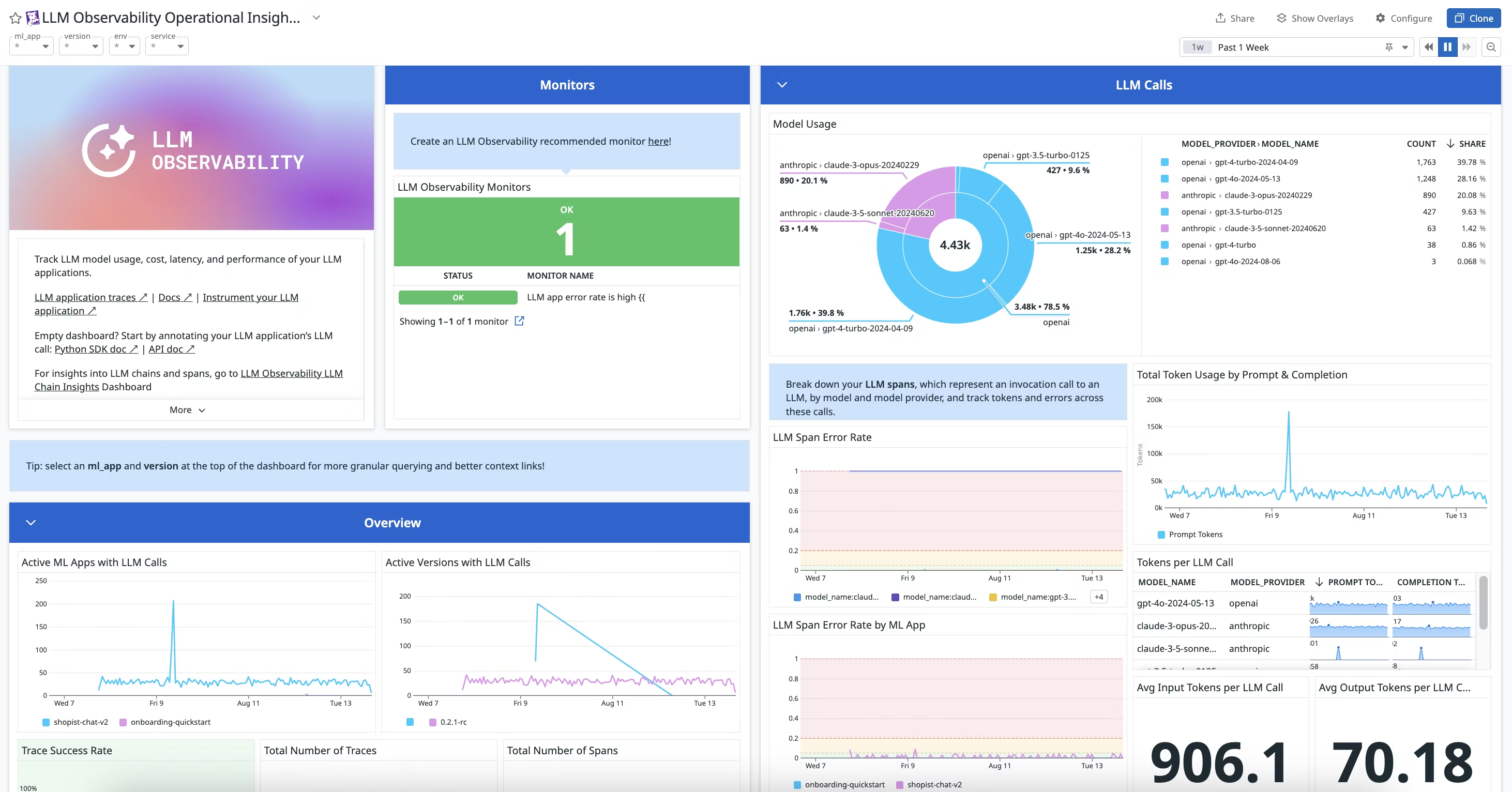

Datadog

馴染みのある方も多いと思われる Datadog も LLM Observability 基盤の提供を行っております。

対応言語として Python, Java, JS/TS で SDK が提供されています。LangChain や VertexAI などのフレームワークに対するインテグレーションも提供されているため、対象のものであれば少ないコードの変更量でトレースを計装できるようになります。しかし言語によってサポートフレームワークが異なっています。

モニタリング、評価、実験の3つを柱として構成しており、それらをリッチなダッシュボードで管理することが可能です。

評価においては Ragas や NeMo などが組み込まれているため、off-the-shelf な LLM-as-a-judge の実施が可能です。これ以外にもカスタムメトリクスを実装することも可能です。

エージェントに特有のマルチターンやツール呼び出しの評価など、LangWatch や Phoenix が提供してくれている部分についての拡張も期待したいところです。

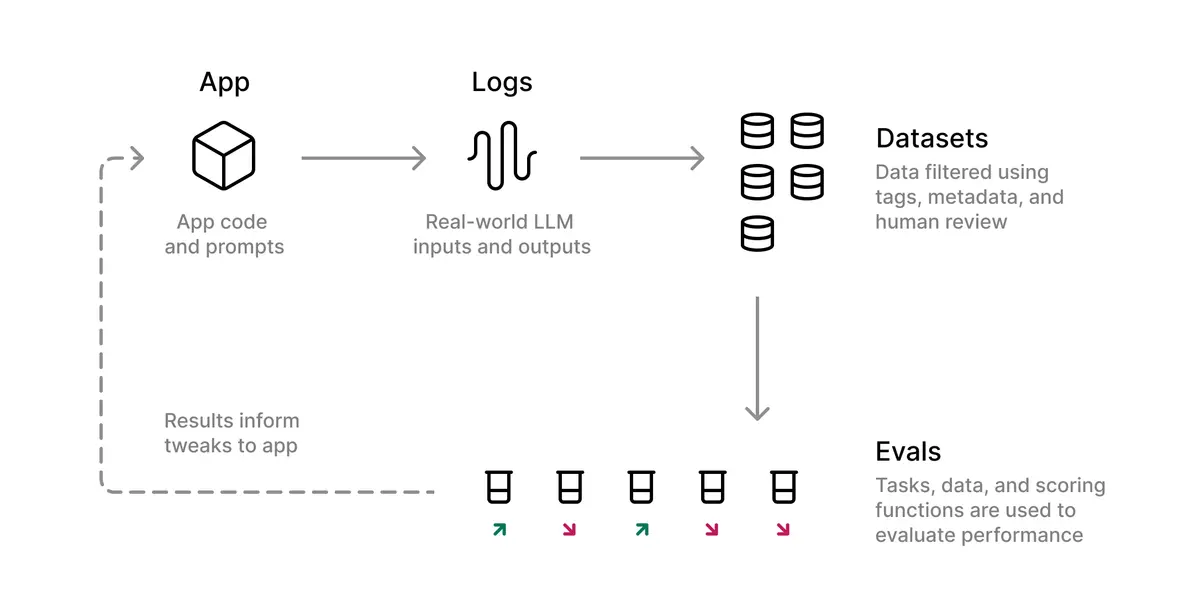

Traceloop

Traceloop は Y Combinator などから出資を受けている企業で、2023 年に設立されています。Traceloop 自体は OSS ではない、商用プラットフォームなのですが、同社によって OpenLLMetry という OSS の標準規格が提唱されています。Traceloop 自体はその上に立つ分析/評価プラットフォームという位置付けになります。対応言語は Python, TS/JS, Go, Ruby になります。トレース、評価、データセットの3つを軸としてサービスが構成されています。他プロバイダーで見たようなプロンプトのバージョニングなどは、記事執筆時点ではなさそうでした。デモページから簡単に使用感を確かめることができます。

OpenLLMetry

OpenLLMetry は OpenTelemetry を「LLM 特有のデータ」に拡張する形で機能します。例えばプロンプトの内容、生成結果、消費トークン量など LLM 特有のデータについて、OTel では標準的な仕様がありませんでした。そこで、OpenLLMetry はその不足分を補う形の標準規格として提唱されている、という位置付けになります。

また OpenLLMetry は Traceloop 以外にも Datadog や Braintrust などの他社ツールへの統合も提供しています。したがって、データ収集基盤として OpenLLMetry を使うことにより、可視化や評価基盤のツールは Traceloop 以外にも様々選べるようになります。(= ベンダーロックインの回避)

OpenLLMetry の対応言語は Python, TS/JS, Go のようです。

OSS プロバイダー

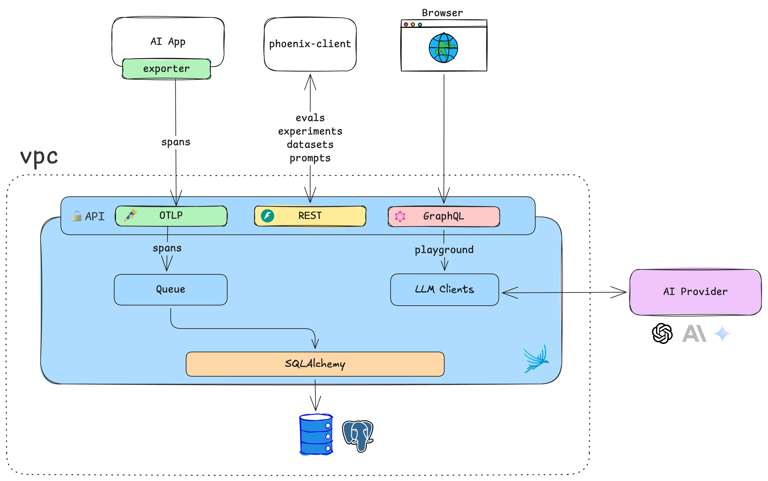

Phoenix

Phoenix は Arize AI によって開発されている OSS (ELv2) の LLM Observability 基盤になります。

セルフホストであっても、料金の発生なしに機能制限なく利用することが可能です。ただし、同社により Arize AX というエンタープライズ向けの有料プラットフォームが用意されていることから、ある種のオープンコアモデルとしても見ることができます。アーキテクチャも比較的シンプルであるため、セルフホスト時の保守・運用コストはそこまで高くなく利用できると考えられます。

対応言語は Python と TS の2種類のようです。

こちらもトレース、評価、実験およびプロンプト管理を主機能として備えています。クラウド、コンテナ、jupyter notebook、ターミナルなど様々な環境で利用することができます。その意味では研究などの実験管理基盤としても利用できるかと思います。

またエージェント周りの評価や RAG などで必要な検索に関する評価なども用意されているため、やれることが細やかに整備されている印象を受けます。

デモも用意されているので、その使用感を簡単に確認することができます。

Phoenix については弊社の別記事でもその使用感を簡単に紹介しているので、興味のある方はぜひご覧ください。

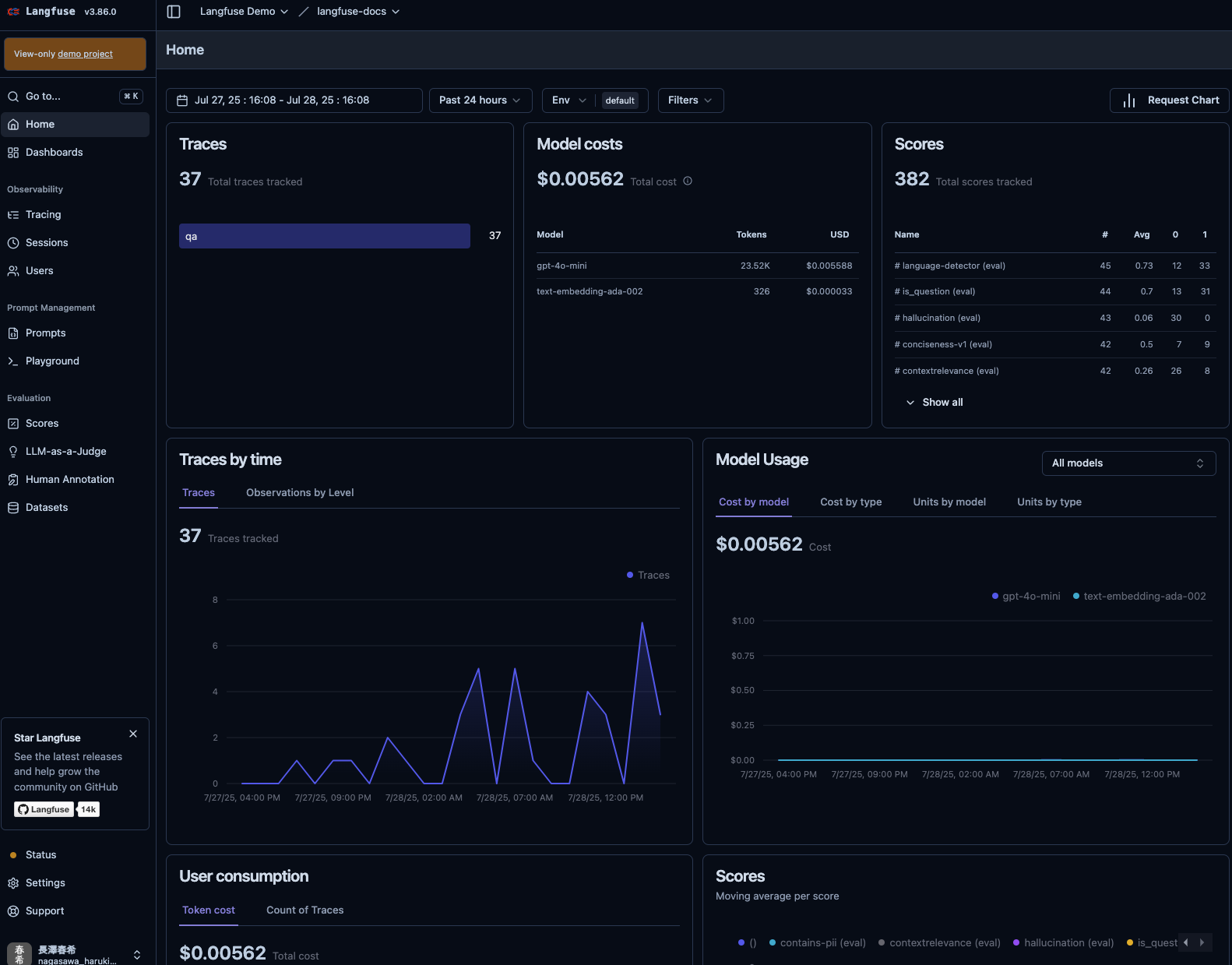

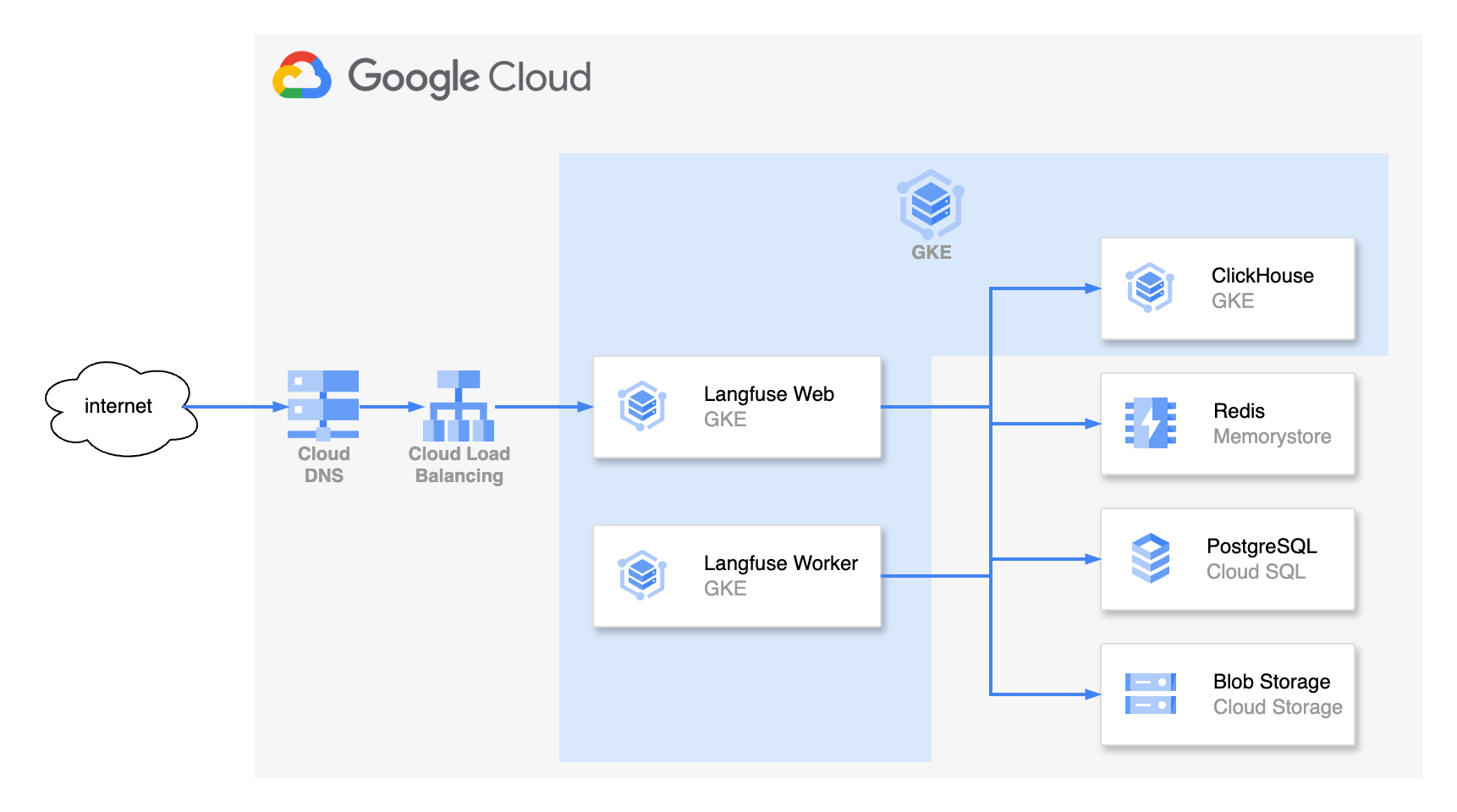

Langfuse

Langfuse はドイツに拠点を構え、Y Combinator からも出資を受ける 2022 年設立の企業になります。

Phoenix と同様、有料プランの加入なしでも、セルフホストでほとんどの機能を利用できるオープンコアの形式をとっています。(基本的には MIT ライセンスですが、一部機能は商用ライセンスが適用されます。) 対応言語は Python, JS/TS になります。

トレース、評価、実験、プロンプト管理などほとんどの主要な機能が提供されています。LLM-as-a-judge の評価においては、Datadog 同様、Ragas などのメトリクスをそのまま利用できます。

ダッシュボードのカスタマイズも可能で、OSS のプロバイダーとしては総合的に完成度が高いように感じられます。デモ画面も用意されているので、気になる方はぜひ覗いてみて下さい。

その反面、アーキテクチャ構成が若干複雑で、セルフホストする場合の保守・運用コストは若干高めかもしれません。ただし、Helm チャートも提供されているので、チャレンジはしやすいように整えられています。

Laminar

Laminar も Y Combinator に出資を受ける、2024 年設立のサンフランシスコの企業になります。

Apache-2.0 ライセンスで開発されており、セルフホストでの運用が可能です。対応言語は JS/TS, Python になります。Laminar 自体のバックエンドは Rust で実装されているため、高速な挙動が期待できます。アーキテクチャは少し複雑ですが、メッセージキューとして RabbitMQ, データは Clickhouse と Postgres を組み合わせたモダンな構成のようです。

こちらもトレース、評価、実験、プレイグラウンドなどの主要な機能がサポートされています。またメッセージキューを使ったデータセットのラベル付けが可能です。

SQL エディタの機能があり、Laminar に格納されているデータに対する読み書きがしやすいインターフェースが提供されています。SQL でトレース情報などを管理・集約されたい方にとっては魅力的な機能かもしれません。

SigNoz

SigNoz は汎用的な APM (Application performance monitoring) ツールという感じで、ポジションとしては Datadog や New Relic と近いですが、OSS (Apache-2.0) として使用できる点に違いがあります。

ドキュメントを見る限り、SigNoz 自体は LLM Observability に特化した機能を提供しているわけではなさそうです。その代わりそれに準ずる OSS との統合を押し出している印象を受けます。

本記事でも紹介している Langtrace や Traceloop などがその統合例として紹介されています。したがって、LLM に対する監視基盤を整えつつ、アプリケーション全体の監視基盤と統合したい場合は SigNoz を使うと良さそう、と言えそうです。

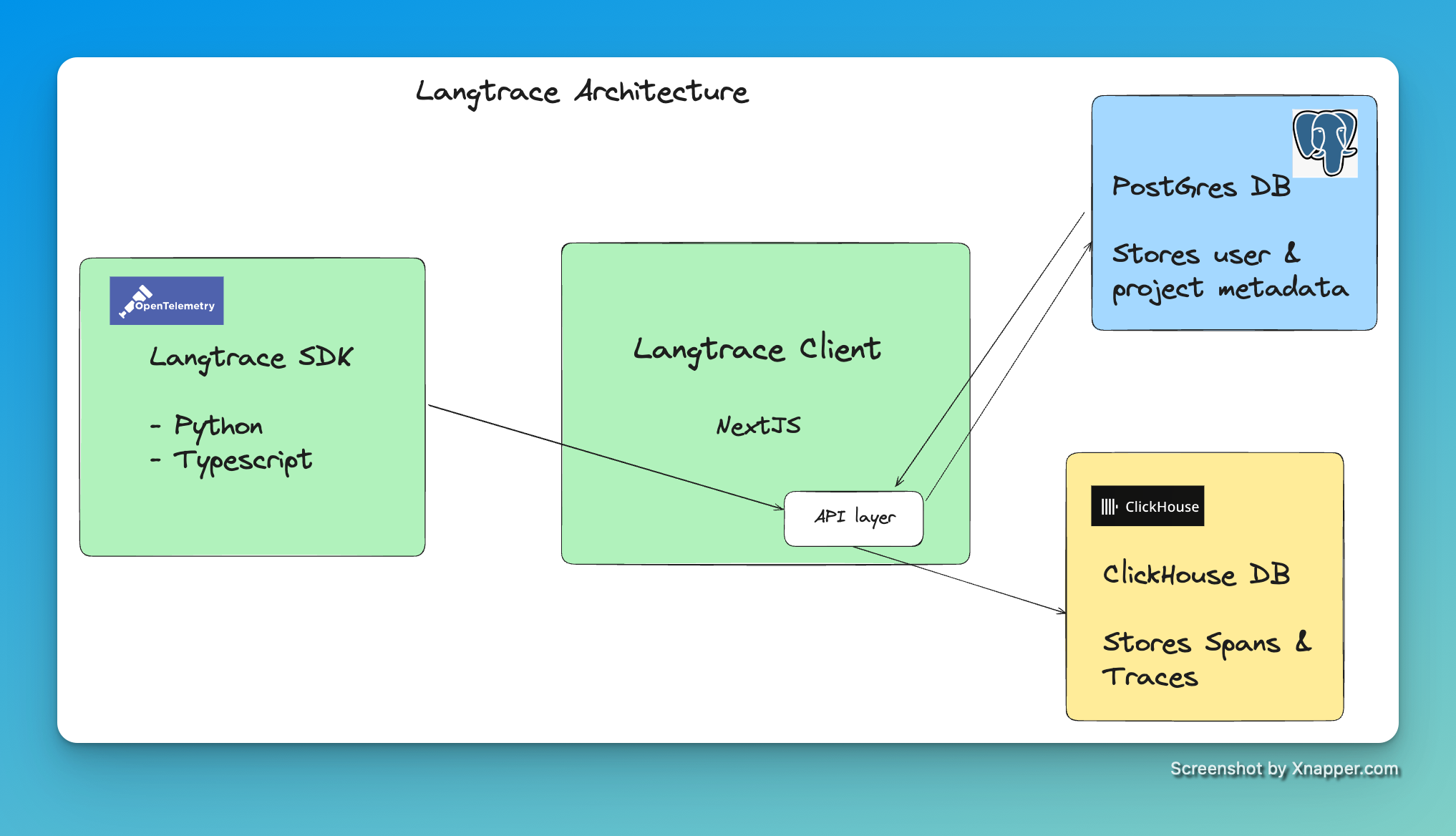

Langtrace

Langtrace は 2024 年 2 月に一般提供が開始された比較的若いツールとなります。Scale3 Labs という企業によって開発されました。同社はもともと Web3 インフラの Observability ツールを開発する企業として 2022 年に設立されたようです。対応言語は Python および TS のみのようです。OSS (AGPL-3.0) として利用でき、セルフホストも可能です。セルフホストの場合、Langtrace の client サーバーに加え、Postgres DB, Clickhouse DB が必要になります。

トークン利用量などを含めたログ・トレースの取得、評価、プロンプトのバージョン管理など LLM Observability で主要な機能は全て揃っているようです。

また、Langtrace は2行の実装のみでトレースが可能になり、その手頃さは魅力的なポイントになります。

まとめ

今回は LLM エージェントの Observability 基盤として使えるプロバイダーをまるっと紹介してみました。単なる監視基盤というより、評価・実験基盤としての意味合いで機能が提供されている点が、LLM Observability ならではな印象を受けました。

基本的な提供機能は概ね共通していましたが、LangWatch や Phoenix はエージェントに特化した評価の整備が進んでいるなど、主に評価基盤における機能の差が見られました。そのほかはダッシュボードや導入のしやすさなどがそれぞれ特色が出るポイントとなりました。導入のしやすさにおいては、インテグレーションの提供有無を見ることも重要です。今回紹介した多くのプロバイダーは Mastra インテグレーションを提供しているため、簡単に組み込むことができます。

個人的にまとめるのであれば、次のようになると思います。

Non-OSS からは、Datadog を APM としてすでに導入している場合は Datadog を、LangChain, LangGraph をエージェントフレームワークとして使用しているのであれば LangSmith を、LLM エージェントの評価にこだわりたいなら LangWatch をおすすめするかなと思います。

OSS の場合は、ダッシュボードなどの UI/UX の良さにこだわるなら Langfuse、手軽さや全体的な網羅性を取るなら Phoenix という感じでしょうか。

これから LLM エージェントの Observability 基盤を導入する方にとって、参考になれば幸いです。