こんにちは。AIチームの東です。

2023年3月15日(水)から3月17日(金)にかけて開催された日本音響学会 第149回(2023年春季)研究発表会にて、AI Shiftと共同研究を行っている名古屋工業大学 李研究室から1件、ポスター発表がありました。

本記事では当日の発表で頂いた質疑応答を抜粋して掲載します。発表内容の概要については前回の記事をご覧ください。

発表報告

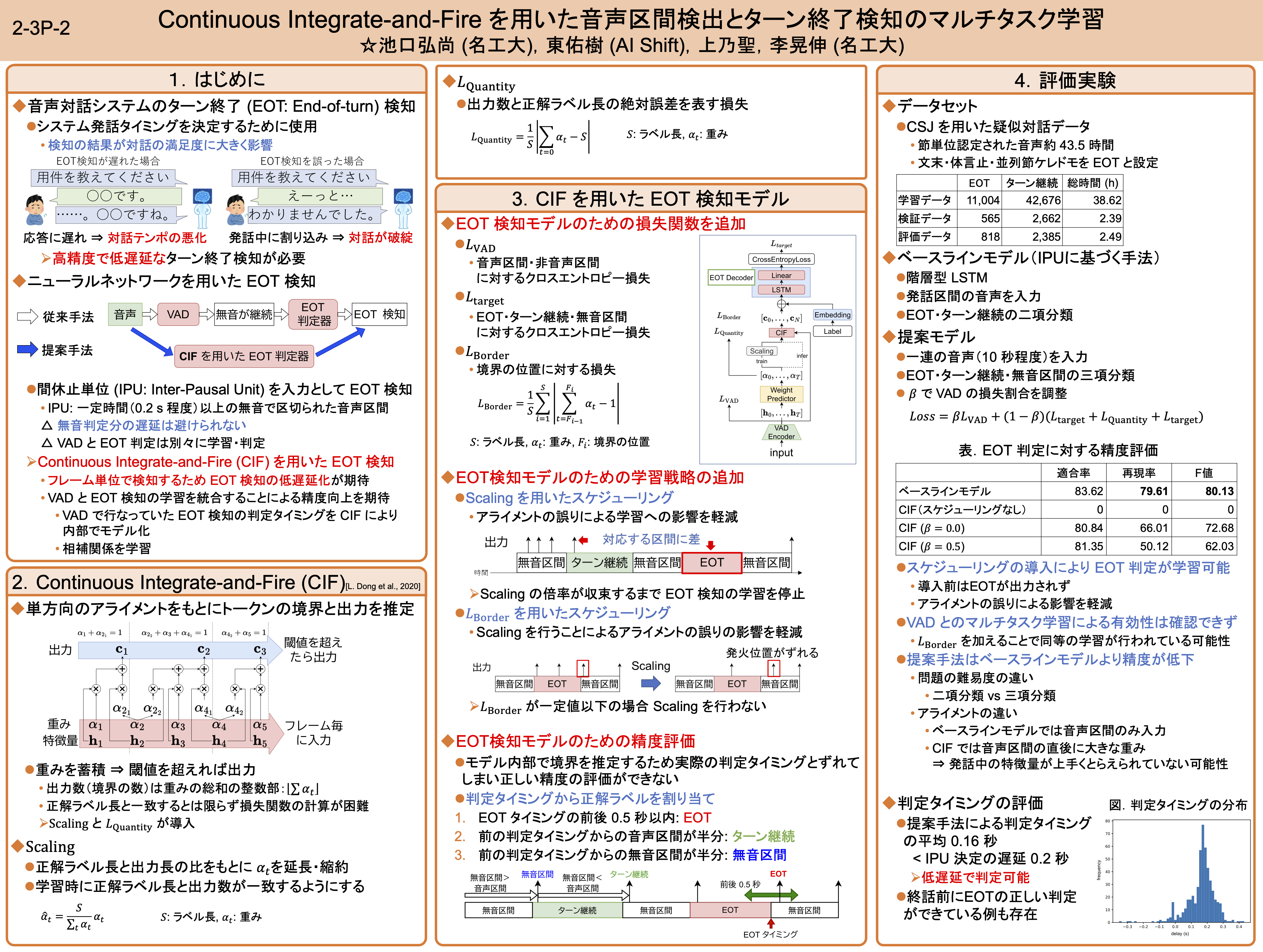

[2-3P-2] Continuous Integrate-and-Fire を用いた音声区間検出とターン終了検知のマルチタスク学習

著者:池口弘尚 (名工大),東佑樹 (AI Shift),上乃聖,李晃伸 (名工大)

議論

■CIF、モデルの挙動、実験結果について:

Q. 特徴量は何を使っているのか

A. 64次元の対数ログメルスペクトログラムを使用している。

Q. 本手法はフレーム毎に何かを予測しているのか?また、αはどのように求められ、何に使われているのか

A. CIFの入力はフレーム毎に与えられるが、出力はフレーム毎に行われるわけではない。αはフレーム毎に求められる値であり、CIFはこの値を蓄積して閾値を超えたタイミングで出力(本研究ではEOT/ターン継続/無音区間)を行うモデルである。

Q. 平均して0.2秒程度の遅延ということだが、どのタイミングで判定結果を出していて、何を予測しているのか

A. CIFの出力はこれまでのフレームから計算されたαの蓄積が閾値を超えたタイミングで出力される。今回の実験では音声区間のフレームが入力された後平均して0.2秒程度遅れて閾値を超えて出力された、という結果になった。予測値はこれまでに入力された区間が無音、話し途中(ターン継続)、話し終わり(EOT)のどれなのかを予測している。

Q. CIFはストリーミング処理の中で暗黙的にEOT検出をやっているという認識だったが、本研究では明示的にEOT検出のための手法として採用して、その精度を検証しているということなのか?

A. CIFは主に音声認識のために用いられ、各単語(トークン)の区切りをモデル化するモジュールである。そのため、本研究のようなEOT検出のタスクとは条件が異なるが、「音声中のある区切りをモデル化する」という点ではEOTに近いような処理と言える部分はあるかもしれない。ただ、音声認識の用途で使われるときはその区切りがEOTとなったり単語や発話の切れ目となったりするため、暗黙的にEOT検出をしているというよりはもう少し大雑把な分類を行なっていると思われる。

■実験設定について:

Q. CSJのデータからどのようにEOTを定義したのか

A. 本研究では文末や体言止め、並列節ケレドモをEOTとして設定した。これは実際の音声対話サービスでのユーザーの発話内容を考慮して決めた基準である。

Q. ベースラインモデルの評価はどうしているのか

A. 音声区間のフレームを入力してその区間が「ターン継続」か「EOT」なのかを2値分類している。

■タスクについて:

Q. 音声の後に無音区間がきてはじめてEOTと判定されるような気がするので、音声が終わる前に結果を予測するというのは難しいのか?また、そういう方向の検討はあるのか?

A. 数としては少ないが、音声の終了を待つ前にEOT判定がされている例は存在するが、適切なモデル化については検討段階である。また、人間は終話の少し前に判定ができるという報告は存在しているので、改善できる可能性はあると考えている。

Q. 本タスクでは別の話者の音声がマイクに入り込む状況は考慮しているのか?

A. 電話音声を前提とした実験であり、基本的に単一話者の音声を扱うため本研究では考慮していない。

Q. 喋ってる間のポーズ、句読点等は本研究でのEOTに対応するのか?またVADと何が違うのか?

A. VADのタスクと異なり、「この後に発話が続く音声」と「ここで発話が終了する音声」を区別している。そのため、音声/非音声区間の2値分類ではなく3値分類のタスクになっている。しゃべっている間のポーズ、句読点等はその直前の音声に「ターン継続」というラベルを設定している。

おわりに

当日はさまざまな観点から議論・コメントをいただきありがとうございました。このような場を提供してくださった運営の皆様に感謝しております。

今後も継続的に発表できるよう、引き続き音声領域での研究開発を続けてまいります。

最後まで読んでいただきありがとうございました!